Der AI Act: Europas Weg zu einer sicheren und verantwortungsvollen KI

Im August 2024 trat der AI Act der EU in Kraft. Dieses Gesetz reguliert KI-Systeme und fördert Innovationen, während es Sicherheit und Grundrechte schützt. Der risikobasierte Ansatz unterteilt Anwendungen in vier Kategorien und legt Anforderungen für Hochrisiko-Systeme fest.

Am 2. August 2024 trat der Artificial Intelligence Act (AI Act) der Europäischen Union in Kraft, ein bahnbrechendes Gesetz, das als weltweit erstes staatenübergreifendes Regelwerk für künstliche Intelligenz (KI) gilt. Dieses umfassende Regelwerk zielt darauf ab, einen ausgewogenen Ansatz zwischen Innovation und Sicherheit zu finden, indem es klare Richtlinien für die Entwicklung, den Einsatz und den Vertrieb von KI-Systemen innerhalb der EU festlegt.

Der AI Act: Europas Antwort auf die KI-Revolution

Künstliche Intelligenz (KI) revolutioniert unseren Alltag in beispiellosem Tempo. Von Sprachassistenten über medizinische Diagnoseverfahren bis hin zu autonomen Fahrzeugen – KI-Technologien durchdringen nahezu alle Lebensbereiche. Diese rasante Entwicklung bietet enorme Chancen, wirft jedoch gleichzeitig kritische Fragen auf, die den Schutz unserer Grundrechte, die Vermeidung von Diskriminierung und den Erhalt unserer Privatsphäre betreffen.

Mit dem AI Act unternimmt die Europäische Union einen wegweisenden Schritt zur Regulierung von KI. Dieses Gesetzesvorhaben ergänzt die bestehende Datenschutz-Grundverordnung (DSGVO) und zielt darauf ab, Innovationen zu fördern, ohne dabei die Sicherheit und Grundrechte der Bürgerinnen und Bürger zu gefährden

Anwendungsbereich und risikobasierter Ansatz

Der AI Act der Europäischen Union definiert und reguliert KI-Systeme und KI-Modelle mit allgemeinem Verwendungszweck.

(Art. 3 Nr. 1 KI-VO)

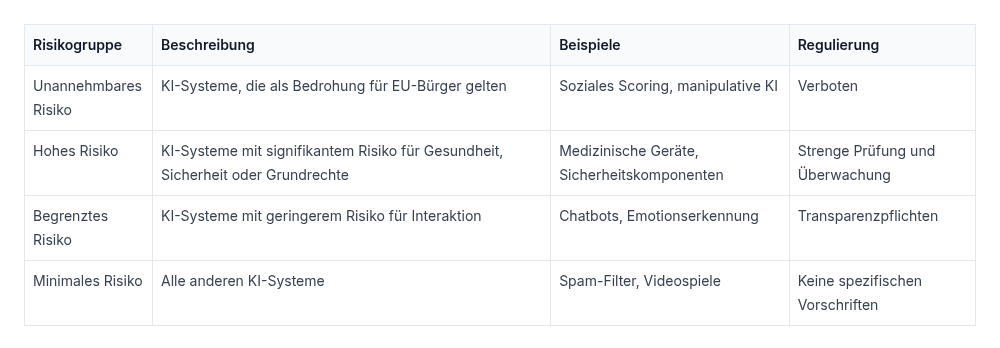

Der AI Act implementiert einen risikobasierten Ansatz zur Regulierung von KI-Systemen. Dieser Ansatz kategorisiert KI-Anwendungen in vier verschiedene Risikogruppen, basierend auf ihrem möglichen Schadenspotenzial. Diese Einteilung bildet die Grundlage für die spezifischen rechtlichen Vorgaben und Anforderungen, die für jedes KI-System gelten. Die Risikokategorien bestimmen somit den regulatorischen Rahmen und die Compliance-Pflichten für Entwickler, Anbieter und Nutzer von KI-Technologien innerhalb der EU.

- Verbotene KI-Praktiken: Dazu zählen Anwendungen, die gegen grundlegende Menschenrechte verstoßen, wie etwa Social Scoring-Systeme nach dem Vorbild Chinas oder manipulative KI-Technologien, die das Verhalten von Menschen unethisch beeinflussen.

- Hochrisiko-Anwendungen: Dazu gehören KI-Systeme in sensiblen Bereichen wie Medizin, Justiz oder Beschäftigung. Diese Systeme unterliegen strengen Anforderungen an Transparenz, Dokumentation und Risikomanagement.

- Begrenztes Risiko: KI-Systeme mit geringeren Risiken müssen Transparenzvorgaben erfüllen. Ein Beispiel sind Chatbots, bei denen Nutzer darüber informiert werden müssen, dass sie mit einer KI interagieren.

- Minimales Risiko: Die meisten KI-Anwendungen, wie z.B. Spamfilter oder KI-gestützte Spiele, fallen in diese Kategorie und unterliegen keinen besonderen Anforderungen.

Geltungsbereich

Der AI Act der Europäischen Union hat einen weitreichenden Anwendungsbereich, der über die Grenzen der EU hinausgeht. Er betrifft auch Unternehmen aus Drittstaaten, die ihre KI-Systeme in Europa auf den Markt bringen. Die Verordnung definiert verschiedene Stakeholder entlang des KI-Lebenszyklus und legt deren Verantwortlichkeiten fest:

- Anbieter (Art. 3 Nr. 3 KI-VO): Entwickeln KI-Systeme und bringen diese auf den Markt oder betreiben sie.

- Betreiber (Art. 3 Nr. 4 KI-VO): Nutzen KI-Systeme eigenverantwortlich, außer für persönliche Zwecke.

- Bevollmächtigter (Art. 3 Nr. 5 KI-VO): Eine in der EU ansässige natürliche Person, die vom Anbieter ermächtigt wurde, bestimmte Pflichten in dessen Namen zu erfüllen.

- Einführer (Art. 3 Nr. 6 KI-VO): Eine in der EU ansässige natürliche Person, die KI-Systeme von außerhalb der EU in die EU bringen.

- Händler (Art. 3 Nr. 7 KI-VO): Stellen KI-Systeme auf dem EU-Markt bereit, sind aber weder Anbieter noch Einführer.

Die KI-Verordnung gilt nicht für Forschung, Tests und Entwicklung vor dem Inverkehrbringen sowie für kostenlose und Open-Source-Software, es sei denn, diese werden als verbotene oder Hochrisiko-KI-Systeme eingestuft. Diese Stakeholder-Definitionen und der breite Anwendungsbereich zeigen, dass der AI Act darauf abzielt, alle relevanten Akteure in der KI-Wertschöpfungskette zu erfassen und zu regulieren, um einen umfassenden Schutz und eine verantwortungsvolle Entwicklung und Nutzung von KI in der EU zu gewährleisten.

Warum ist der AI Act notwendig?

Der AI Act adressiert die potenziellen Gefahren, die von KI-Systemen ausgehen können, wie Diskriminierung, intransparente Entscheidungsprozesse oder Verletzungen der Grundrechte. Ein Beispiel hierfür ist der Einsatz von Gesichtserkennungssystemen im öffentlichen Raum, der erhebliche Datenschutzbedenken aufwirft.

Der AI Act regelt nun den Einsatz von Gesichtserkennungssystemen im öffentlichen Raum streng. Grundsätzlich ist deren Nutzung verboten, jedoch mit spezifischen Ausnahmen für Sicherheitsbehörden. Diese dürfen die Technologie zur Verfolgung schwerer Straftaten wie Terrorismus einsetzen, müssen dabei aber strenge Auflagen beachten. Biometrische Daten dürfen jedoch nicht mit sensiblen persönlichen Informationen verknüpft werden.

Mögliche Sanktionen:

Die KI-Verordnung sieht strenge Sanktionen für Verstöße gegen ihre Bestimmungen vor. Die Bußgelder sind gestaffelt und können je nach Schwere des Verstoßes erhebliche Summen erreichen:

- Für Verstöße gegen die Verbote der KI-VO:

Bis zu 35 Millionen Euro oder 7% des weltweiten Jahresumsatzes - Bei Verstößen gegen Vorschriften für Hochrisiko-KI-Systeme oder GPAI-Modelle:

Bis zu 15 Millionen Euro oder 3% des weltweiten Jahresumsatzes - Für die Bereitstellung falscher Informationen gegenüber zuständigen Behörden:

Bis zu 7,5 Millionen Euro oder 1,5% des weltweiten Jahresumsatzes

Für kleine und mittlere Unternehmen gelten Sonderregelungen, bei denen der jeweils niedrigere Betrag als Bußgeld verhängt wird. Neben den Bußgeldern haben die Marktaufsichtsbehörden weitere Möglichkeiten zur Durchsetzung der Verordnung. Sie können beispielsweise nicht-konforme Hochrisiko-KI-Systeme vom Markt nehmen und deren Einsatz untersagen, bis die Konformität wiederhergestellt ist. Diese strengen Sanktionen unterstreichen die Entschlossenheit der EU, eine verantwortungsvolle Entwicklung und Nutzung von KI-Systemen sicherzustellen.

Fazit: KI-Regulierung als Balanceakt

Der AI Act zeigt, dass die Europäische Union bei der Regulierung von KI-Technologien eine Vorreiterrolle einnimmt. Er soll sicherstellen, dass KI-Systeme im Einklang mit unseren Grundrechten stehen und gleichzeitig Raum für Innovationen lassen.

Doch die Umsetzung dieser Regeln wird eine komplexe Aufgabe sein, die Unternehmen, Gesetzgeber und Gesellschaft gleichermaßen betrifft. Nur durch Zusammenarbeit und Transparenz kann es gelingen, eine Zukunft zu gestalten, in der KI als Chance statt als Bedrohung wahrgenommen wird.

Quelle:

Europäische Union: Verordnung über künstliche Intelligenz. Amtsblatt der Europäischen Union, Reihe L 2024/1689.